ALL YOU NEED IS ATTENCION

Las 7 páginas de un artículo científico que dieron comienzo a la era de la Inteligencia Artificial en 2017. Un descubrimiento: los transformers y toda una aventura llena d eobstáculos y enemigos para poder desarrollarla.

CIENCIA

Tlonia

12/14/20241 min leer

TODO EMPEZÓ CON UN POQUITO DE ATENCIÓN.

Parece una canción de los Beatles. Y en ella está inspirado el título.

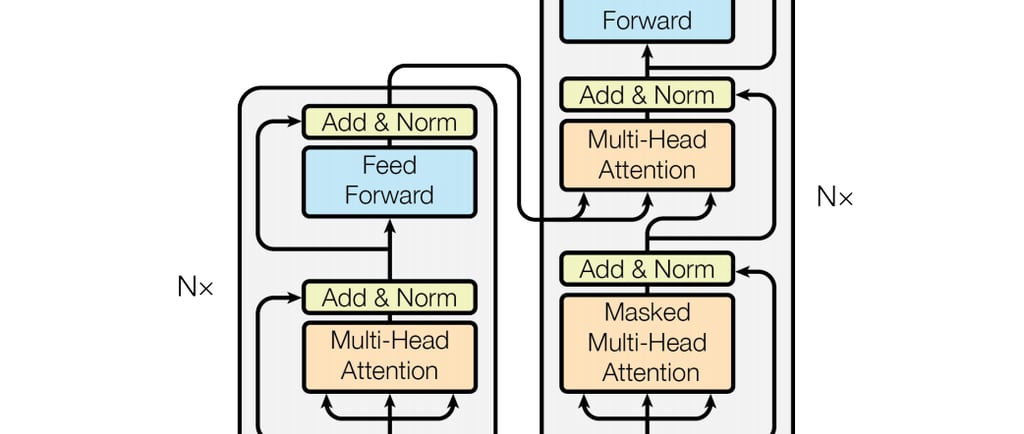

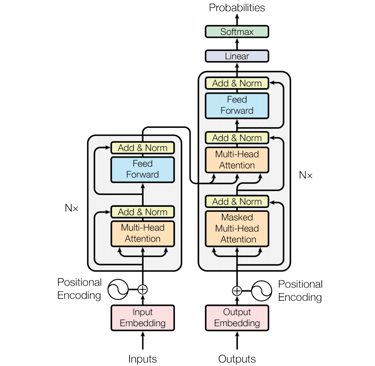

El artículo "All You Need Is Attention" ha marcado un hito en el desarrollo de la inteligencia artificial, sentando las bases para la arquitectura de los transformers. Publicado en 2017, este trabajo de Vaswani et al. propuso un modelo que prioriza la atención en lugar de la recurrencia, lo que revolucionó la forma en que se procesan las secuencias de datos. Gracias a su capacidad para captar relaciones a largo plazo y su escalabilidad, los transformers han transformado el campo del procesamiento del lenguaje natural (NLP) y han impulsado avances significativos en otras áreas de la IA. Hoy en día, modelos como BERT y GPT-3, que se basan en esta arquitectura, están a la vanguardia de la investigación y aplicación de la inteligencia artificial, facilitando tareas complejas y mejorando la interacción humano-máquina. La innovación presentada en este paper ha sido fundamental para la evolución del aprendizaje profundo en la actualidad.

Todo empezó con las transformers. Y no fue una aventura cualquiera. Fue una carrera de obstáculos e impedimentos.

Aquí un video de nuestra querido divulgador Gustavo Entrala que lo explica. Año 2017.